ه½““و•°وچ®â€وˆگن¸؛ن¼پن¸ڑوœ€و ¸ه؟ƒçڑ„资ن؛§ï¼Œو”»ه‡»è€…çڑ„ç›®ه…‰ن¹ںن»ژç³»ç»ں边界转هگ‘ن؛†و•°وچ®وœ¬è؛«م€‚ن½ هڈ¯èƒ½ç†ںو‚‰ç½‘络IOCï¼ڑوپ¶و„ڈIPم€پو–‡ن»¶ه“ˆه¸Œم€پهڈ¯ç–‘هںںهگچم€‚ن½†è؟™ن؛›وŒ‡و ‡هœ¨é¢ه¯¹ن؛‘ه؛“م€پAPIم€پو•ڈوچ·ه¼€هڈ‘ه’Œه†…ه®،éپ—و¼ڈو—¶ه¾€ه¾€ه¤±çپµم€‚و•°وچ®IOC(DataIndicatorsofCompromise)ن¸چوک¯هڈ¦ن¸€ن¸ھه®‰ه…¨èٹ±هگچه†Œï¼Œه®ƒوک¯وٹٹو•°وچ®è‡ھè؛«çڑ„特ه¾پم€پè®؟é—®è،Œن¸؛ه’Œن¼ و’è·¯ه¾„وٹ½è±،ن¸؛هڈ¯و£€ç´¢م€پهڈ¯ه‘ٹè¦م€پهڈ¯è؟½و؛¯çڑ„“وƒ…وٹ¥هچ•ه…ƒâ€م€‚

وƒ³è±،ن¸€ن¸‹ï¼ڑن¸چوک¯é ن¸€ن¸ھ被هٹ¨çڑ„ç¾هگچ,而وک¯ن¾èµ–“وںگه¼ è،¨هœ¨éه·¥ن½œو—¶é—´è¢«و‰¹é‡ڈه¯¼ه‡؛ه¹¶ه‡؛çژ°هœ¨ه¼‚ه¸¸ç›®çڑ„هœ°â€çڑ„è،Œن¸؛ç؛؟索;ن¸چوک¯ç®€هچ•هˆ¤و–و•ڈو„ںه—و®µوک¯هگ¦è¢«è®؟问,而وک¯ç»“هگˆè®؟问频و¬،م€پوں¥è¯¢و¨،ه¼ڈم€پ请و±‚و¥و؛گه’Œو•°وچ®ه†…ه®¹وŒ‡ç؛¹و¥هˆ¤و–é£ژ险م€‚è؟™ه°±وک¯و•°وچ®IOCçڑ„ن»·ه€¼ï¼ڑوٹٹهˆ†و•£çڑ„ن؟،وپ¯è½¬وˆگ能直وژ¥é©±هٹ¨è°ƒوں¥ن¸ژه“چه؛”çڑ„ن؟،هڈ·م€‚

çژ°ه®و،ˆن¾‹ه¸¸ه¸¸ه¾ˆو™®é€ڑï¼ڑن¸€هگچه¼€هڈ‘ن؛؛ه‘که› 调试وƒé™گه¯¼ه‡؛ن؛†ه®¢وˆ·و•°وچ®ï¼Œéڑڈهگژ误ن¸ٹن¼ هˆ°ه…±ن؛«ç›کï¼›هڈˆوˆ–وک¯ن¸€و®µè¢«و¤چه…¥هگژé—¨çڑ„è„ڑوœ¬ه®ڑوœںو±‡و€»è،¨و ¼ه¹¶هڈ‘é€پç»™ه¤–部邮箱م€‚ن¼ ç»ںDLPن¾èµ–ه…³é”®è¯چه’Œè§„هˆ™ï¼Œه½“规هˆ™ن¸چه®Œو•´وˆ–و•°وچ®و ¼ه¼ڈه¤ڑو ·و—¶ن¼ڑه‡؛çژ°ه¤§é‡ڈ误وٹ¥وˆ–و¼ڈوٹ¥م€‚و•°وچ®IOCه¼•ه…¥ن؛†و›´ه¤ڑç»´ه؛¦â€”—è،Œن¸؛ه؛ڈهˆ—م€په†…ه®¹وŒ‡ç؛¹م€په…ƒو•°وچ®هڈکهŒ–م€په…³èپ”è·¯ه¾„ç‰ï¼Œه½¢وˆگ“ه¤چهگˆوŒ‡و ‡â€م€‚

é€ڑè؟‡è؟™ç±»ه¤چهگˆوŒ‡و ‡ï¼Œه®‰ه…¨ه›¢éکں能وٹٹو³¨و„ڈهٹ›èپڑ焦هœ¨é‚£ن؛›çœںو£وœ‰ه¼‚ه¸¸ç‰¹ه¾پçڑ„و•°وچ®ن؛‹ن»¶ن¸ٹ,而ن¸چوک¯è¢«ه™ھه£°و·¹و²،م€‚

èگ½هœ°ه¹¶ééپ¥ن¸چهڈ¯هڈٹï¼ڑن»ژو•°وچ®èµ„ن؛§و¢³çگ†ه¼€ه§‹ï¼Œو ‡و³¨و•ڈو„ںهںںم€په»؛ç«‹و•°وچ®è،€ç¼کن¸ژè®؟é—®و—¥ه؟—,结هگˆوœ؛ه™¨ه¦ن¹ وڈگهڈ–و£ه¸¸è®؟问画هƒڈ,ه†چه®ڑن¹‰ه¼‚ه¸¸و¨،و؟,é€گو¥ç§¯ç´¯و•°وچ®IOCه؛“م€‚ه…³é”®وک¯è¦پوٹٹè؟™ن؛›IOCن¸ژçژ°وœ‰ه®‰ه…¨وژ§هˆ¶ï¼ˆSIEMم€پDLPم€پCASBم€پSOAR)èپ”هٹ¨ï¼Œهپڑهˆ°â€œهڈ‘çژ°-éھŒè¯پ-ه“چه؛”â€ن¸€ن½“هŒ–م€‚

ن¸‹ن¸€éƒ¨هˆ†ه°†و·±ه…¥è®²è§£ه¦‚ن½•و„ه»؛ه®è·µè·¯ه¾„م€پوٹ€وœ¯è¦پ点ن¸ژè،،é‡ڈوŒ‡و ‡ï¼Œه¸®هٹ©ن½ وٹٹ视角ن»ژ“ن؟ه®ˆه°په µâ€è½¬ن¸؛“精ه‡†و‰“ه‡»â€م€‚ه‡†ه¤‡ه¥½وٹٹé‚£ن؛›çœ‹ن¸چè§پçڑ„هچ±é™©هڈکوˆگن¸€ن¸²هڈ¯و“چن½œçڑ„ç؛؟ç´¢ن؛†م€‚

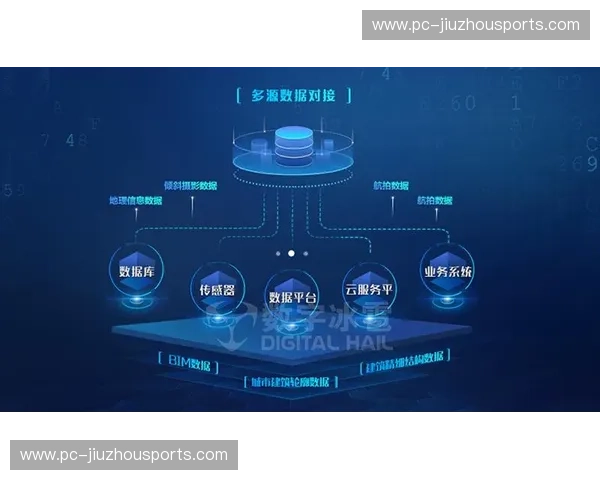

ن»ژو¦‚ه؟µهˆ°ه®è·µï¼Œو„ه»؛و•°وچ®IOCن½“ç³»هڈ¯ن»¥هˆ†وˆگه‡ و¥ï¼ڑ第ن¸€و¥وک¯ه…¨é¢و¢³çگ†و•°وچ®هœ°ه›¾م€‚و¸…و¥ڑçں¥éپ“و•°وچ®هœ¨ه“ھ里م€پè°پ能è®؟é—®م€پé€ڑè؟‡ن»€ن¹ˆé€”ه¾„وµپهٹ¨ï¼Œوک¯هˆ¶ه®ڑIOCçڑ„هں؛ç،€م€‚第ن؛Œو¥وک¯هˆ†ç±»ن¸ژوŒ‡ç؛¹هŒ–م€‚ه¯¹و•ڈو„ںو•°وچ®è؟›è،Œه—و®µç؛§هˆ†ç±»ï¼Œه¹¶ç”¨ه†…ه®¹وŒ‡ç؛¹م€پو¨،ç³ٹه“ˆه¸Œوˆ–è¯ن¹‰ç¾هگچه¯¹و•°وچ®ه؟«ç…§ه»؛و¨،,ن¾؟ن؛ژهœ¨è·¨ç³»ç»ںو£€ç´¢و—¶هڈ‘çژ°ç›¸ن¼¼و³„露片و®µم€‚

第ن¸‰و¥وک¯è،Œن¸؛ç”»هƒڈن¸ژهں؛ç؛؟ه»؛ç«‹م€‚é€ڑè؟‡é•؟وœں采集وں¥è¯¢و—¥ه؟—م€پAPI调用م€په¯¼ه‡؛/ن¸‹è½½è®°ه½•ï¼Œهˆ©ç”¨ç»ںè®،ن¸ژMLو–¹و³•ç”ںوˆگو£ه¸¸è،Œن¸؛و¨،ه‹ï¼Œن»»ن½•هپڈ离都هڈ¯ن½œن¸؛IOC触هڈ‘ه› ç´ م€‚第ه››و¥وک¯ه…³èپ”ن¸ژو؛¯و؛گ,وٹٹهچ•ç‚¹ه¼‚ه¸¸ن¸²èپ”ن¸؛ن؛‹ن»¶é“¾ï¼ڑç™»ه½•ه¼‚ه¸¸â†’ه¤§é‡ڈه¯¼ه‡؛→ه¤–部ن¼ 输,ه½¢وˆگن¼که…ˆç؛§و›´é«کçڑ„ه¤چهگˆIOC,وژ¨هٹ¨ه؟«é€ںه“چه؛”م€‚

وٹ€وœ¯é›†وˆگه±‚é¢ï¼Œو•°وچ®IOCوœ€ه¥½ن¸ژçژ°وœ‰ه®‰ه…¨و ˆهچڈهگŒï¼ڑوٹٹIOCن½œن¸؛وƒ…وٹ¥è¾“ه…¥هˆ°SIEMه’ŒUEBA,ن¾›ه¨پèƒپç‹©çŒژه’Œه‘ٹè¦هٹ وƒï¼›ن¸ژDLPه’ŒCASBèپ”هٹ¨ه®çژ°ه®و—¶éک»و–وˆ–هٹ ه¯†ï¼›ن¸ژSOAR结هگˆè‡ھهٹ¨و‰§è،Œéڑ”离م€په›و»ڑوˆ–é€ڑçں¥وµپ程م€‚è‡ھهٹ¨هŒ–能وٹٹن؛؛ه·¥ه·¥ن½œé‡ڈن»ژ“وµ·é‡ڈو—¥ه؟—->ن؛؛ه·¥ç›é€‰â€è½¬ن¸؛“é«کç½®ن؟،ه‘ٹè¦->ه؟«é€ںه¤„ç½®â€م€‚

هˆ¶ه®ڑه¸¸و€پهŒ–çڑ„هڈچ馈وœ؛هˆ¶ï¼Œوٹٹو¯ڈو¬،ن؛‹ن»¶çڑ„éھŒçœں结وœم€پ误وٹ¥هژںه› ن¸ژIOCوœ‰و•ˆو€§ç؛³ه…¥è؟ن»£ï¼ŒوŒپç»ن¼کهŒ–特ه¾په؛“م€‚

è،،é‡ڈو•ˆوœن¸چè¦پهڈھ看ه‘ٹè¦و•°é‡ڈ,而è¦په…³و³¨و›´وœ‰و„ڈن¹‰çڑ„وŒ‡و ‡ï¼ڑو•°وچ®و³„露ه¹³ه‡و£€وµ‹و—¶é•؟(MTTD)م€په“چه؛”و—¶é•؟(MTTR)م€پ误وٹ¥çژ‡ن¸ژن؛‹ن»¶ه½’ه› و•ˆçژ‡م€‚è،Œن¸ڑه؛”用هœ؛و™¯ه¾ˆه؟«وک¾çژ°ن»·ه€¼ï¼ڑ金èچوœ؛و„é€ڑè؟‡و•°وچ®IOCهœ¨ن؛¤وک“ه¼‚ه¸¸ن¸وچ•èژ·ن؛†éوژˆوƒه¯¼ه‡؛,éپ؟ه…چن؛†ه¤§è§„و¨،ه®¢وˆ·ن؟،وپ¯و³„露;هŒ»ç–—وœ؛و„ه€ںهٹ©ه†…ه®¹وŒ‡ç؛¹هœ¨ن؛‘è؟پ移ن¸è¯†هˆ«ه‡؛و•ڈو„ںè®°ه½•çڑ„وœھوژˆوƒه¤چهˆ¶ï¼Œè؟…é€ںن؟®ه¤چوƒé™گé…چç½®م€‚

ن¼پن¸ڑه®و–½è·¯ه¾„ه»؛议采用“è§پ 九州体育APPو•ˆه؟«م€پوٹ•ه…¥هڈ¯وژ§â€çڑ„试点ç–ç•¥ï¼ڑه…ˆهœ¨é«کن»·ه€¼و•°وچ®هںں部署,éھŒè¯پ规هˆ™ه¹¶و‰©ه±•هˆ°و›´ه¤ڑو•°وچ®و؛گم€‚

结ه°¾è¦پ点و¸…و™°ï¼ڑو•°وچ®IOCن¸چوک¯é”و³•ï¼Œن¹ںن¸چوک¯è´ںو‹…,ه®ƒوک¯وٹٹ“و•°وچ®ه®‰ه…¨â€ن»ژéک²ه®ˆه¢™ه¤–çڑ„ç¾هگچهچ‡ç؛§ن¸؛و•°وچ®ه†…部çڑ„وƒ…وٹ¥هŒ–è؟گن½œم€‚ه¯¹ن»»ن½•ه¸Œوœ›هœ¨ن؛‘و—¶ن»£ن؟وŒپç«ن؛‰هٹ›ن¸ژهگˆè§„و€§çڑ„组织و¥è¯´ï¼Œوگه»؛ن¸€ه¥—هڈ¯و‰©ه±•çڑ„و•°وچ®IOCن½“系,و„ڈه‘³ç€هœ¨وœ€ه…³é”®çڑ„资ن؛§ن¸ٹèژ·ه¾—ه‰چو‰€وœھوœ‰çڑ„هڈ¯è§†هŒ–ن¸ژوژ§هˆ¶هٹ›م€‚è‹¥ن½ و£è€ƒè™‘ن¸‹ن¸€و¥çڑ„ه®‰ه…¨وٹ•èµ„,وٹٹو³¨و„ڈهٹ›ن»ژ“و›´ه¤ڑ规هˆ™â€è½¬هگ‘“و›´èپھوکژçڑ„وƒ…وٹ¥هŒ–و£€وµ‹â€â€”—è؟™وک¯وٹٹé£ژ险转هŒ–ن¸؛هڈ¯و“چن½œن¼کهٹ؟çڑ„è·¯ç؛؟م€‚